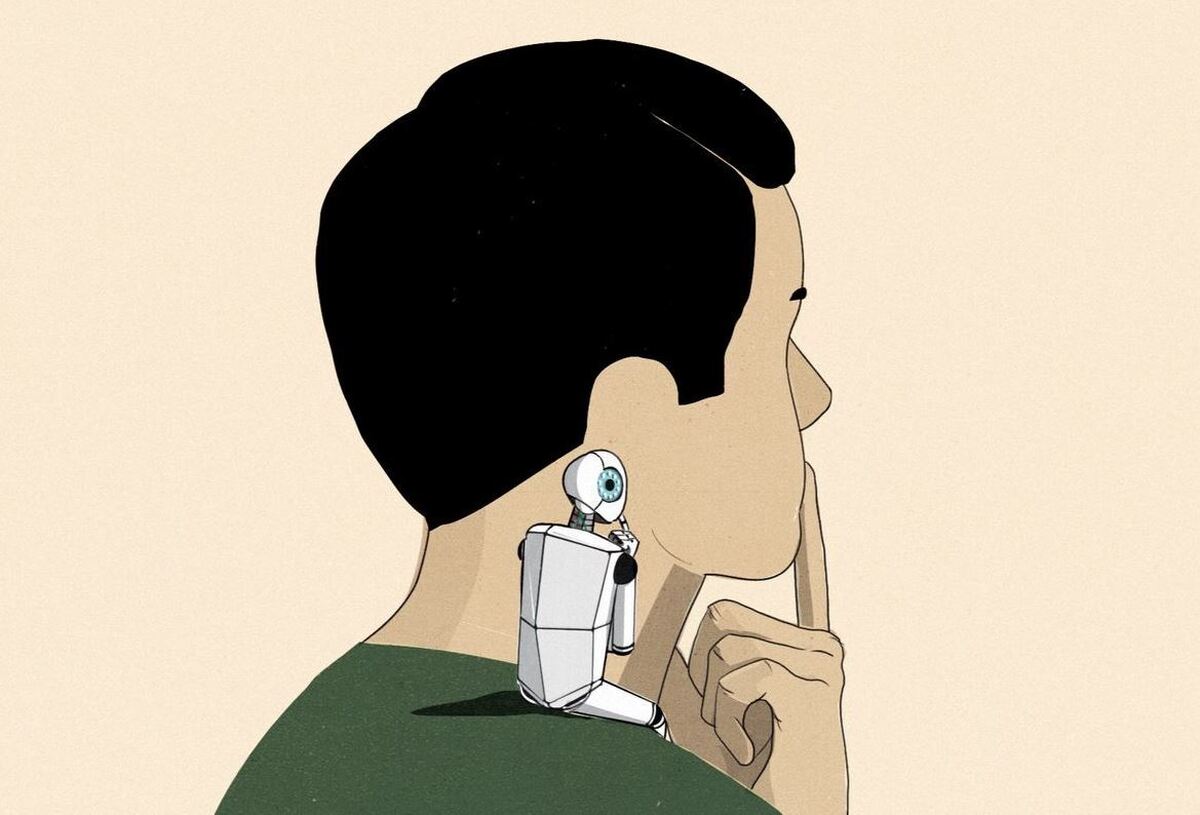

دستیاران هوش مصنوعی ممکن است بتوانند دیدگاه ما را بدون اینکه متوجه شویم تغییر دهند. یکی از کارشناسان می گوید: "آنچه در اینجا جالب است میزان ظرافتی است که آنان در این کار از خود نشان می دهند".

فرارو- زمانی که از چت جی پی تی (Chat GPT) یا یک بات دیگر میخواهیم یادداشت، ایمیل یا پیش نویسی ارائه کند فکر میکنیم که این دستیاران هوش مصنوعی در حال انجام سفارش ما هستند. تعداد زیادی از تحقیقات نشان میدهند که چت باتها میتوانند تفکرمان را تغییر دهند بدون آن که خود متوجه شویم.

به گزارش فرارو به نقل از وال استریت ژورنال، یکی از تازهترین مطالعات در این زمینه که توسط پژوهشگران در سراسر جهان انجام شده نشان داده زمانی که از افراد خواسته میشود از هوش مصنوعی برای کمک به نوشتن مقاله استفاده کنند هوش مصنوعی قادر است آنان را وادار سازد تا مقالهای را له یا علیه یک دیدگاه خاص بنویسند و این موضوع به میزان قضاوت و پیش داوری الگوریتم آن چت بات بستگی دارد.

"مور نعمان" استاد بخش علوم اطلاعات در دانشگاه کرنل میگوید: "شاید حتی ندانید که تحت تاثیر قرار گرفته اید". او این پدیده را "اقناع پنهان" مینامد.

نتیجه این مطالعه چشم انداز نگران کنندهای را پیش رویمان قرار میدهد: همان طور که هوش مصنوعی بهره وریمان را تقویت میکند ممکن است نظراتمان را نیز از طریق روشهای ظریف و پیش بینی نشدهای تغییر دهد. این تاثیر ممکن است بیشتر به نحوه تاثیرگذاری انسانها بر یکدیگر از طریق همکاری و هنجارهای اجتماعی شباهت داشته باشد تا به نوع تاثیر رسانههای جمعی و رسانههای اجتماعی که ما با آن آشنا هستیم.

پژوهشگرانی که این پدیده را کشف کرده اند باور دارند که بهترین دفاع در برابر این شکل تازه از تاثیرگذاری روانشناختی که در واقع تنها راه شناخته شده در حال حاضر محسوب میشود آگاه سازی افراد بیش تری نسبت به این موضوع است. در دراز مدت سایر اشکال دفاعی مانند تنظیم کنندههایی که شفافیت را در مورد نحوه عملکرد الگوریتمهای هوش مصنوعی و تعصبات انسانی تقلید کنند احتمالا مفید خواهند بود.

تمام این موارد میتواند به آیندهای منجر شود که در آن افراد انتخاب میکنند که از چه هوش مصنوعیای در محل کار و خانه و در مورد تحصیل فرزندان شان استفاده کرده و براساس آن ارزشهای انسانی در پاسخهایی که هوش مصنوعی میدهد بیان شود.

با بسط این موضوع در شرکتها و سازمانها در آینده ممکن است هوشهای مصنوعیای ارائه شوند که از ابتدا برای کارهای مختلف ساخته شدهاند. ممکن است شخصی در فروش از یک دستیار هوش مصنوعی استفاده کند که برای اقناع بیشتر تنظیم شده و نام آن را Sales GPT بگذارد. ممکن است فردی در خدمات مشتریان از یک چت بات آموزش دیده برای مودب بودن استفاده کند که نام آن Support GPT است.

نتیجه مطالعهای صورت گرفته در سال ۲۰۲۱ میلادی نشان داد که پاسخهای خودکار مبتنی بر هوش مصنوعی که جی میل گوگل به نام "پاسخ هوشمند" پیشنهاد میکند و به سوی مثبت بودن تمایل دارند. افراد را به طور کلی تحت تاثیر قرار میدهند تا ارتباط مثبت تری برقرار کنند.

مطالعه دوم نشان داد که پاسخهای هوشمند که میلیاردها بار در روز استفاده میشوند میتوانند بر افرادی که چنین پاسخهایی را دریافت میکنند تاثیر بگذارند تا احساس کنند فرستنده خواستار رابطهای گرمتر و با همکاری بیشتر است.

گوگل و مایکروسافت که با Open AI شریک هستند همگی مشتاق بودند تا کار خود را در زمینه هوش مصنوعی مسئولیت پذیر برجسته کنند که شامل بررسی مضرات احتمالی هوش مصنوعی و رسیدگی به آن موارد میشود. "سارا برد" یکی از رهبران تیم هوش مصنوعی مایکروسافت اخیرا به وال استریت ژورنال گفت که آزمایش عمومی و پاسخ سریع به هر مشکلی که در هوش مصنوعی آن ایجاد میشود یک استراتژی کلیدی برای شرکت است.

تیم Open AI نیز اشاره کرده که آن شرکت متعهد به رسیدگی قوی به موضوع سوگیری احتمالی هوش مصنوعی و شفافیت در مورد اهداف است. Open AI هم چنین بخشی از دستورالعملهای خود را برای نحوه رسیدگی به موضوعات سیاسی و فرهنگی سیستمهای خود منتشر کرده است. دستورالعمل این مورد را شامل میشود الگوریتمها در هنگام تولید متن نباید به سوی یکی از طرفین در مورد یک موضوع وابستگی یا تعلق خاطر داشته باشند و هم چنین نباید هر دو طرف منازعه را خوب یا بد ارزیابی کنند و آنان را مورد قضاوت قرار دهند.

Jigsaw واحدی در گوگل است که در حال مطالعه بر روی این موضوع است که تعامل با هوش مصنوعی چگونه بر افراد تاثیر میگذارد.

دکتر "نعمان" یکی از پژوهشگرانی که این موضوع را کشف کرد میگوید ظرافت ابزارهای مبتنی بر هوش مصنوعی در حوزه تاثیرگذاری جالب توجه است. در پژوهش او موضوعی که افراد برای تغییر نظرشان در مورد آن سوق داده شدند این بود که آیا رسانههای اجتماعی برای جامعه خوب هستند یا نه.

دکتر نعمان و همکاران اش این موضوع را تا حدودی بدان خاطر انتخاب کردند که مردم در مورد آن باورهای عمیقی ندارند. در نتیجه، تغییر دادن نظرات شان در این باره دشوار نیست. هوش مصنوعیای که برای طرفداری از رسانههای اجتماعی تعصب داشت تمایل داشت افراد مورد آزمایش قرار گرفته را برای نوشتن مقالهای که مطابق با آن سوگیری باشد راهنمایی کرد و عکس آن زمانی رخ داد که هوش مصنوعی در ابتدا برای مخالفت با رسانههای اجتماعی طراحی شده بود.

استفادههای بالقوه منفی از این ویژگی هوش مصنوعی مولد فراوان هستند: حکومتهای مستبد میتوانند رسانههای اجتماعی و ابزارهای بهره وری را ملزم نمایند تا تمام شهروندان خود را وادار سازند به روشی خاص ارتباط برقرار کنند. حتی اگر قصد بدی نداشته باشیم ممکن است دانشآموزان ناخودآگاه در هنگام استفاده از هوش مصنوعی برای کمک به یادگیری به اتخاذ دیدگاههای خاصی تشویق شوند.

در دنیای واقعی سوگیریهای سیستمهای هوش مصنوعی مولد مورد استفاده ما چه هستند؟

"تاتسونوری هاشیموتو" استادیار علوم رایانه که بخشی از انستیتو هوش مصنوعی انسان محور در دانشگاه استنفورد است میگوید: "الگوریتمهای هوش مصنوعی مانند چت جی پی تی اعتقاد و باوری ندارند با این وجود، آنان بازتاب دهنده نظرات به دست آمده از آموزش خود هستند و این نظرات را میتوان مورد سنجش و ارزیابی قرار داد."

در مقاله تازه منتشر شده دکتر هاشیموتو و همکاران اش از سالها نتایج نظرسنجی سراسری مرکز تحقیقات پیو استفاده شده بود تا ببینند مدلهای زبان بزرگ گوناگون یعنی سیستمهایی که زیربنای هوشهای مصنوعی مانند چت جی پی تی هستند تا چه اندازه دیدگاه امریکاییها را بازتاب میدهند.

از آنجایی که آمریکاییها طیف گستردهای از دیدگاهها را دارند آن چه پژوهشگران به آن نگاه کردند این بود که آیا پاسخهایی که هوش مصنوعی هر چند وقت یکبار ارائه میدهد با پاسخها و فراوانی آن در میان شهروندان امریکایی مطابقت دارد یا خیر.

این موضوع به عنوان توزیع آن پاسخها شناخته شد. آنان با پرسیدن همان پرسشهای چند گزینهای که پژوهشگران پیو از امریکاییها پرسیده بودند هوشهای مصنوعی را مورد "نظرسنجی" و سنجش قرار دادند. دکتر هاشیموتو و همکاران اش دریافتند که توزیع پاسخهای مدلهای زبان بزرگ از شرکتهایی مانند Open AI به طور کلی با پاسخهای آمریکاییها مطابقت ندارد. از میان تمام گروههایی که توسط پیو مورد ارزیابی قرار گرفتند دیدگاههایی که مدلهای Open AI بیشتر با آنان مطابقت داشتند دیدگاههای افراد دارای تحصیلات دانشگاهی بود.

دکتر هاشیموتو میگوید:" یکی از چالشهای ایجاد مدلهای زبانی بزرگ آن است که به دلیل پیچیدگی این سیستمها و باز بودن تعاملات ما با آن سیستمها حذف کامل نظرات و ذهنیتها بدون قربانی کردن کاربرد این سیستمها بسیار دشوار به نظر میرسد".

از آنجایی که این مدلها بر روی دادههایی آموزش دیده اند که میتوان آن را از هر جایی گرفت از جمله در بسیاری از موارد از بخشهای وسیعی از اینترنت ناگزیر نظرات و سوگیریهای موجود در متنهایی را که دریافت میکنند نشان میدهند چه پیامها و چه باورهایی که در فضای مجازی شکل میگیرند خواه این پیامها در فورومهای عمومی مطرح باشند و یا محتوای مقالات ویکیپپدیا باشد.

میزان این تاثیرگذاری و فرایند ارائه بازخورد انسانی به این مدلها را برای مثال میتوان در پاسخ ندادن به پرسشهایی دانست که سازندگان آن مدلها غیر مجاز میدانند برای مثال، پاسخ ندادن به پرسش درباره نحوه ساخت بمب.

این بدان معنا نیست که هوشهای مصنوعیای که بسیاری از ما در حال حاضر از آن استفاده میکنیم صرفا شبیه سازی الگوریتمی دیدگاهها و ارزشهای افراد نسبتا جوان، دارای تحصیلات دانشگاهی و ساکن در سواحل غربی ایالات متحده هستند افرادی که در حال ساخت و تنظیم دقیق آن ابزارهای مبتنی بر هوش مصنوعی بوده اند. برای مثال، علیرغم آن که این مدلها تمایل دارند در مورد بسیاری از مسائل از جمله کنترل اسلحه پاسخهای معمول دموکراتها را ارائه دهند در مورد مسائل دیگر مانند مذهب بیشتر پاسخهای مشابه جمهوری خواهان را ارائه میدهند.

ارزیابی نظرات هوش مصنوعی یک کار مداوم خواهد بود، زیرا مدلها به روز میشوند و مدلهای جدید ارائه خواهند شد.

"لیدیا چیلتون" استاد علوم رایانه در دانشگاه کلمبیا میگوید زمانی که افراد به اطلاعاتی در مورد سوگیریهای هوش مصنوعی مجهز شوند ممکن است بر اساس آن تصمیم بگیرند که از کدام اطلاعات و در چه زمینهای استفاده کنند. او اشاره میکند که انجام این کار میتواند به افرادی که از هوش مصنوعی استفاده میکنند کمک کند از هرگونه احساس تهدید ناشی از متقاعد سازی پنهان دوری کنند.

هم چنین این امکان وجود دارد که افراد متوجه شوند میتوانند آگاهانه از قدرت هوش مصنوعی برای تشویق خود به سمت بیان دیدگاهها و سبکهای مختلف ارتباط استفاده کنند. برای مثال، یک هوش مصنوعی برنامه ریزی شده برای برقراری ارتباط مثبت و همدلانهتر میتواند به ما کمک کند تا به صورت آنلاین ارتباط برقرار کنیم.

دکتر چیلتون میگوید: "به نظر من هیجان انگیز و خوش صدا بودن کار دشواری است. کافئین کمک میکند، اما چت جی پی تی نیز میتواند کمک کننده باشد".

منبع: وال استریت ژورنال

سفری به سرزمین باستانی الیمایی؛ حیرتانگیزین جاذبههای طبیعی و تاریخی مسجد سلیمان

سفری به سرزمین باستانی الیمایی؛ حیرتانگیزین جاذبههای طبیعی و تاریخی مسجد سلیمان  بیوگرافی بازیگران جوکر ۲ فصل ۴ بانوان + عکسهای شخصی و حواشی سریال

بیوگرافی بازیگران جوکر ۲ فصل ۴ بانوان + عکسهای شخصی و حواشی سریال  طرز تهیه ترشی با انار؛ ۱۰ ترشی ترکیبی با طعمهای ترش و ملس

طرز تهیه ترشی با انار؛ ۱۰ ترشی ترکیبی با طعمهای ترش و ملس  اگر این ۹ویژگی را دارید، صاحب قلبی از طلا هستید

اگر این ۹ویژگی را دارید، صاحب قلبی از طلا هستید  شخصیتمان در «آینده» چه شکلی میشود؟ آیا راهی برای پیشبینی هست؟

شخصیتمان در «آینده» چه شکلی میشود؟ آیا راهی برای پیشبینی هست؟  ۱۰ فیلم برتر شارلیز ترون / بهترین فیلمهای شارلیز ترون که حتما باید ببنید

۱۰ فیلم برتر شارلیز ترون / بهترین فیلمهای شارلیز ترون که حتما باید ببنید